– 서울시민 AI 일상화 3대 프로젝트 중 하나인 윤리 가이드라인 발표

– 3대 기본원칙 기반으로 생성형 AI 위험 유형에 따라 9대 핵심요건 도출

– 재단 “시민교육과 윤리문화 확산을 통해 AI 건전 활용에 앞장설 것”

※ AI확산 이면의 AI위험(가짜뉴스‧개인정보 침해 등)에 대한 시민 안전을 위해 선제적 활용

□ 서울디지털재단(이사장 강요식)은 지난 10월 26일 제시한 서울시민 인공지능(AI) 일상화 3대 프로젝트 중 하나인 서울시 생성형 AI 윤리 가이드라인을 발표했다.

○ 서울시 생성형 AI 윤리 가이드라인은 정부의 디지털 권리장전 제정과 분야별 윤리 가이드라인을 마련한다는 정부 정책의 기조를 이어받기 위한 노력의 일환으로 마련되었다.

□ 이번 윤리 가이드라인은 생성형 AI 특성과 서울시 핵심가치를 기반으로 연구한 것이 특징이며, 이용자를 중심으로 운영자·개발자가 지켜야 할 윤리적 준수사항을 함께 포함하였다.

○ 본 윤리 가이드라인은 민간기업에 대한 규제적 접근이 아닌 이용자·운영자·개발자가 생성형 AI를 안전하게 활용할 수 있도록 자율적으로 준수할 수 있는 규범을 제시한다는 취지이다.

□ 산‧학‧연 여러 전문가의 의견을 수차례 수렴하여 윤리 가이드라인에 대한 추진방향 및 3대 기본원칙을 도출하였고, 이를 바탕으로 9대 핵심요건을 제시하였다.

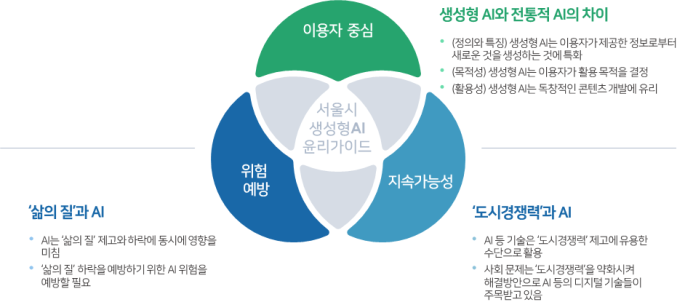

□ 윤리 가이드라인은 ‘이용자 중심, 위험예방, 지속가능성’을 3대 기본원칙으로 선정하였다.

○ ‘기본원칙’은 생성형 AI의 특성(이용자 의도에 따라 능동적인 결과 생성)과 서울시 핵심가치(‘삶의질’, ‘도시경쟁력’)를 토대로 도출하였다.

○ ‘이용자 중심’은 생성형 AI에 대한 이용자의 참여 정도에 따라 새로운 위험요인이 나타나기 때문에 ‘이용자를 중심’으로 한 윤리 가이드라인 마련이 필요하다는 내용이다.

○ ‘위험예방’은 삶의 질을 향상시키기 위해서는 AI의 활용만큼이나 위험을 최소화할 필요가 있기 때문에 생성형 AI의 위험을 기반으로 핵심요건을 도출해야 한다는 내용이다.

○ ‘지속가능성’은 도시경쟁력을 약화시키는 범죄, 환경오염 등의 도시 문제를 생성형 AI를 통해 해소할 필요가 있으며, 이를 위해 윤리 가이드라인에 지속가능성의 개념이 필요하다는 내용이다.

□ 윤리 가이드라인은 3대 기본원칙을 바탕으로 ‘이용자의 검증 역량, 책임성, 데이터 권리와 책임, 사용가능성 확보, AI 학습데이터 안전성, AI 윤리 소양, 공공성, 생태적 지속가능성, 보안성’을 9대 핵심요건으로 제시하였다.

○ 핵심요건 도출을 위해 국내외 생성형 AI의 위험을 제시한 문헌과 발표자료를 조사·분석하고 위험의 유사성에 따라 유형을 구분하였다.

○ 또한 유형별 실제 사례를 분석해 이해관계자별로 착안할 수 있는 쟁점을 도출하고 이를 기존 윤리원칙이 어떻게 해석하는지 분석하였으며, 분석 결과를 기반으로 이해관계자가 준수해야 할 핵심요건을 도출하였다.

□ 또한, 이해관계자(이용자·운영자·개발자)가 윤리 가이드라인의 핵심요건을 준수하기 위해 알아야 할 핵심요건별 위험유형과 실제사례와 함께 배경과 주의사항이 ‘가이드라인’에 제시된다.

○ 윤리 가이드라인이 적극 확산되고 활용되기 위해서는 이해관계자가 처한 위험 유형을 정확하게 인지하고, 이에 맞는 준수사항을 인지할 필요가 있다.

□ 강요식 서울디지털재단 이사장은 “생성형 AI가 확산되는 가운데, 가짜뉴스, 개인정보 침해 등 AI 위험 우려도 커지는 상황이다. 이에 재단은 시민의 안전을 위해 선제적으로 지자체 최초의 생성형 AI 윤리 가이드라인을 발표하게 되었다”며, “이를 통해 시민들이 안전하고 편리하게 AI를 활용하기를 기대하며, 우리 재단도 시민교육, 윤리문화 확산 활동을 통해 건전한 AI 활용문화 조성을 위해 노력할 것”이라고 밝혔다.